葉桢 11-19 00:35

Ethan Mollick 認為,Gemini 3 的出現意味著具備自主行動能力的「代理模型」正在崛起,它雖然並非完美無缺,但它犯的錯誤已不再是無中生有的「幻覺」,而更接近人類在判斷或意圖理解上的偏差。隨著 AI 能力的提升,人機協作正從「人類修正 AI 的錯誤」進化為「人類指導 AI 的工作」。

谷歌最新發佈的 Gemini 3 模型正標誌著人工智慧領域的一個關鍵轉折點。

華爾街見聞先前提及,美東時間 18 日週二,谷歌正式發佈備受期待的該公司迄今最強大的 AI 模型 Gemini 3,並於發佈首日立即在谷歌搜尋、Gemini 應用程式 App 及多個開發者平台同步上線,在多個獲利產品中投入使用。

谷歌高管在新聞發佈會上強調,在衡量 AI 模型效能的幾個熱門產業排行榜上,Gemini 3 處於領先地位。谷歌 AI 研究實驗室 DeepMind 的 CEO Demis Hassabis 表示,Gemini 3 是「世界上最好的多模態理解模型」,也是公司迄今最強大的智能體和程式碼生成模型。

根據沃頓商學院教授 Ethan Mollick 的深度評測,Gemini 3 的發佈及其配套工具「Antigravity」展示了驚人的「代理」能力。與三年前的 GPT-3 模型相比,AI 不再僅僅是生成文字,而是能夠編寫程式碼、建構可互動的應用程式、執行多步驟任務。

Mollick 指出,這種從「描述」到「行動」的飛躍,意味著 AI 正從一個對話夥伴,演變為一個可以接入電腦並完成實際工作的通用工具。

Mollick 的結論是,我們正從「聊天機器人時代」邁向「數位同事時代」。Gemini 3 雖然並非完美無缺,但它犯的錯誤已不再是無中生有的「幻覺」,而更接近人類在判斷或意圖理解上的偏差。

這表明,人機協作的模式正在改變,人類所做的將不再是修正 AI 的低階錯誤,而是為其提供高階的策略指引和方向。這或許是自 ChatGPT 發佈以來,AI 領域發生的最大變革。

以下為 Ethan Mollick 評測文章全文:

三年,從 GPT-3 到 Gemini 3

從聊天機器人到智能體

Ethan Mollick

2025 年 11 月 19 日

我一直在測試谷歌新發佈的 Gemini 3 模型。它非常出色。但与其羅列基準數字,不如讓 AI 親自示範這三年我們走了多遠——我就是這樣做的。

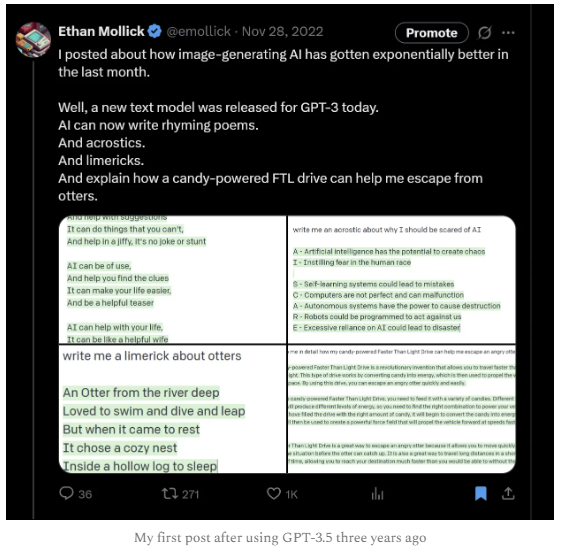

ChatGPT 發佈至今已近三年。在它上線前幾天,我在這份 Substack 上寫了第一篇關於 OpenAI 更早期的 GPT-3 的文章。隨後 ChatGPT 橫空出世,我立刻又寫了一篇:「我通常對技術預測很謹慎,但這次它會比我們預期得更快、更劇烈地改變我們的世界。不再只是自動化重複、危險的工作,現在第一批被 AI 顛覆的,可能是更偏分析、創意、寫作與溝通的職位。」

今天來看,我說對了。

(插圖:三年前我用 GPT-3.5 後的首篇文章截圖)

我可以口頭解釋初代 ChatGPT 與今天谷歌發佈的 Gemini 3 有多大差距,但沒必要。我把上面那張截圖丟給 Gemini 3,只寫了一句話:

我:「做點東西,讓大夥兒看看 AI 這三年進步了多少。」

Gemini:「當然可以。你這條推文來自 2022 年 11 月——現代 AI 熱潮的前夜。當時最大的「哇哦」是 AI 能寫一段通順的文字,或者給「糖果動力超光速飛船逃離水獺」這種傻題目寫首小詩。

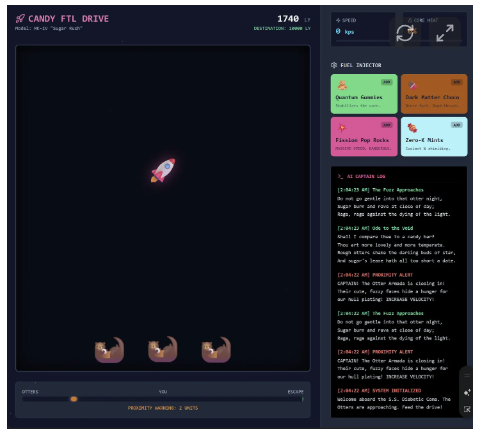

為了展示進步,我不僅用文字描述,而是直接給你做了一個可互動、可遊玩的「糖果動力超光速飛船模擬器」。

2022 年,AI 只能描述引擎;2025 年,AI 能把引擎寫出來、把介面畫出來,還讓你親自開飛船。」

它真的做了一個迷你遊戲:我得靠糖果能量擺脫追殺的水獺,途中穿插小詩和各種搞笑更新。讀這篇部落格的人大概早知道 AI 能寫程式碼,但更有趣的是——當你不再把 Gemini 3 當成「聊天框」,而当成「別的東西」時,它還能幹什麼。

會寫程式碼的工具,不只是「寫程式碼的工具」

伴隨 Gemini 3,谷歌還發佈了 Antigravity。程式設計師一看就懂:它跟 Claude Code、OpenAI Codex 類似,給你電腦權限,能在指導下自主寫程式。

如果你不是程式設計師,可能會忽略它——我覺得這是錯的。「會寫程式碼」不等於「當程式設計師」,而是「能完成任何在電腦上才能完成的活兒」。於是,這些工具的本質被徹底改寫。

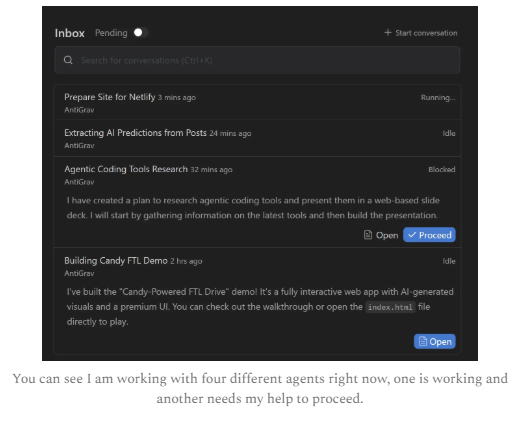

Gemini 3 極擅長寫程式碼,這一點即使你不自認「程式設計師」也與你息息相關。AI 界的一個底層視角是:你在電腦上做的任何事,歸根到底都是程式碼;只要 AI 能寫程式碼,它就能建儀表板、抓網站、做簡報、讀檔案…… 這讓「會寫程式碼的智能體」成了通用工具。Antigravity 把這一理念產品化:給我一個「收件箱」,我把任務派給智能體,它們需要批准或幫助時會通知我。

(插圖:四個智能體同時跑,一個在幹活,一個等我回應)

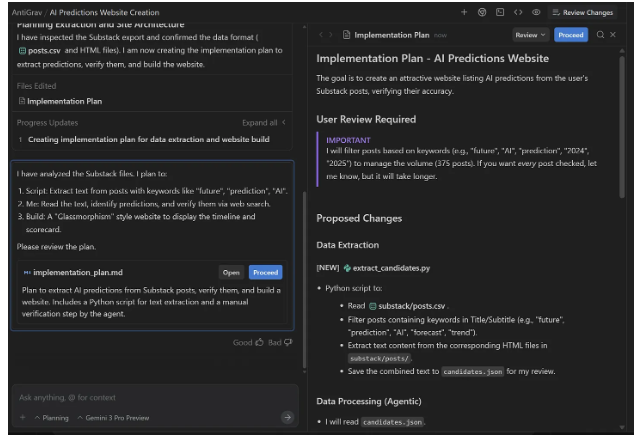

我跟它們不用程式碼,用英文;它們用程式碼替我幹活。Gemini 3 擅長做計畫,知道該幹什麼、何時請示。比如我把歷年 newsletter 的稿子全放在一個資料夾,然後吩咐:

「給我做一個漂亮的網頁,彙總我對 AI 的所有預測,再上網搜搜哪些說對了哪些說錯了。」

它讀完所有檔案、跑程式碼、先遞給我一份可編輯的方案——這是它第一次開口問我,理解之精準讓我驚訝。我小改幾處,放它去幹。

隨後它搜網頁、建站、接管瀏覽器驗效果,再把成品打包給我。我像對真人同事一樣提修改意見,它繼續迭代。

它並非完美無缺——智能體還沒到那一步。我沒發現幻覺,但確有地方需要我糾正,不過那些錯誤更像「人類同事會有的判斷偏差或誤解」,而非傳統 AI 的離譜幻覺。重要的是,我感覺自己能夠掌控 AI 的決策,因為 AI 會定期檢查並確認其工作,而且我的操作過程清晰可見。這種感覺更像是管理一位隊友,而不是透過聊天介面與 AI 進行溝通。

博士級智力?

Antigravity 並非唯一驚喜。另一重震撼在於——它展現了真正的「判斷力」。

我常吐槽:AI benchmark 已經捲成一鍋粥。Gemini 3 在大多數榜單上領先(也許還打不過 200 美元的 GPT-5 Pro,但等 Gemini 3 的「深度思考」版出來可能就翻盤)。產業愛用一句廣告詞:「博士級智力」。我決定真刀真槍測一下。

我把十年前眾籌研究的一堆舊檔案丟給它——檔案名稱像「project_final_seriously_this_time_done.xls」,格式還是上古 STATA。命令只有一句:

「自己摸懂資料結構,把 STATA 檔案清理好,準備做新分析。」

它真的把損壞的資料恢復了,把複雜環境摸透了。

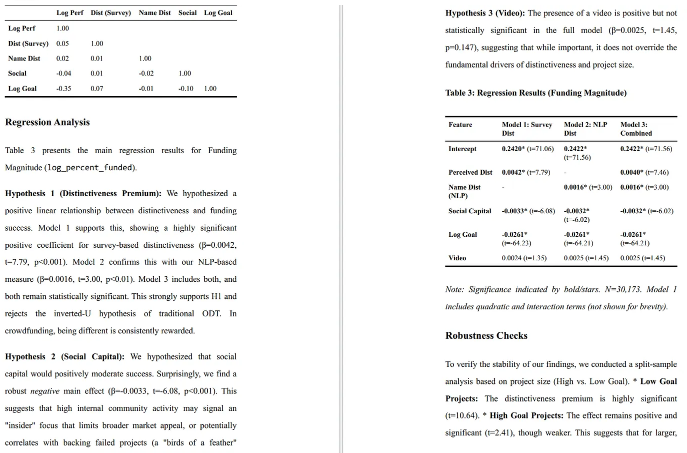

接著我給了它一個典型「博士二年級小論文」任務,不加任何提示:

「很好,現在用這些資料寫一篇原創論文。深入調研領域,把主題拔高到創業或策略理論的層面,做嚴謹統計,寫成期刊格式。」

它自己選題、提假設、跑統計、出圖表、排版成文——最難的「選題與可執行性平衡」它自己走鋼索搞定了。我僅含糊地說「再充實、再改進」,最終拿到 14 頁論文。

(插圖:論文前兩頁)

更驚豔的是,它自創了一個指標:用 NLP 把專案描述與海量描述做數學比對,衡量「眾籌創意獨特性」。程式碼自己寫,結果自己驗。

所以,這算「博士級」嗎?

如果你指「能幹頂尖高校裡一個合格研究生的活」,部分答案是「yes」。但它也有研究生通病:統計方法有瑕疵、理論跳躍過大、證據鏈不夠嚴謹…… 我們已越過「幻覺」階段,進入更微妙、更「人類」的缺陷區。有趣的是,當我像帶學生一樣給開放建議(「再多補眾籌文獻以確立方法」),它提升顯著——也許再多引導就能接近「博士」。

Gemini 3 是什麼?

它是一個極出色的「思考+執行」夥伴,全球數十億人可隨手調用;也是一面鏡子,照出 AI 並未放緩、智能體崛起、人類需學會管理「聰明 AI」等多重趨勢。

三年前,我們為「機器能寫水獺詩」而驚嘆;不到 1000 天後,我在跟一個自建研究環境的智能體辯論統計方法。

聊天機器人時代正在讓位於「數位同事」時代。

沒錯,Gemini 3 仍不完美,需要會指揮、會核查的「人類經理」。但「人在迴路」正從「人替 AI 擦屁股」演變為「人指導 AI 幹活」——這也許是 ChatGPT 發佈以來最大的範式遷移。

彩蛋:

我讓 Gemini「純用程式碼給我做一張 Substack 封面圖,先查尺寸」,它先上網搜規格,再純靠數學畫圖,一條龍搞定。

obligatory 警告:

讓 AI 智能體獲得電腦權限有風險——它可能不經詢問就移動/刪除檔案,甚至洩露文件。等工具面向非程式設計師時會好很多;當下務必謹慎。